探索 DeepSeek V3 的技術創新

January 7, 2025

探索 DeepSeek V3 的技術創新

DeepSeek V3 作為開源 AI 模型中的重要成員,以卓越的創新與效率表現脫穎而出。其擁有高達 6710 億參數,但每個 token 僅有 370 億參數被啟用,在確保效能的同時大幅降低資源消耗。本文將深入介紹使 DeepSeek V3 與眾不同的關鍵技術創新。

核心技術特性

Mixture‑of‑Experts(MoE)架構

DeepSeek V3 的核心是 Mixture‑of‑Experts(MoE) 架構。此高階設計讓模型能夠協同調用多個較小、專注於特定任務的子網路。當接收到查詢時,gating 網路會判定需啟用的專家,確保僅啟用必要的組件,從而大幅提升效率與效能。

Multi‑head Latent Attention(MLA)

DeepSeek V3 採用 Multi‑head Latent Attention(MLA) 以加強上下文理解與資訊擷取。此方法在維持高效能的同時,透過低秩壓縮降低推論期間的記憶體使用量,讓模型能在不犧牲準確度的情況下高效處理複雜查詢。

無輔助損失的負載平衡

DeepSeek V3 的一項亮點在於其 無輔助損失(auxiliary‑loss‑free)的負載平衡策略。傳統負載平衡方法可能對模型效能造成不利影響;此創新做法有效降低該影響,使訓練過程更穩定且高效。

多 Token 預測訓練目標

DeepSeek V3 引入 多 Token 預測的訓練目標,強化其產生連貫且具脈絡關聯文字的能力。模型可同時預測多個 token,進一步提升生成速度與整體效率。

效能指標

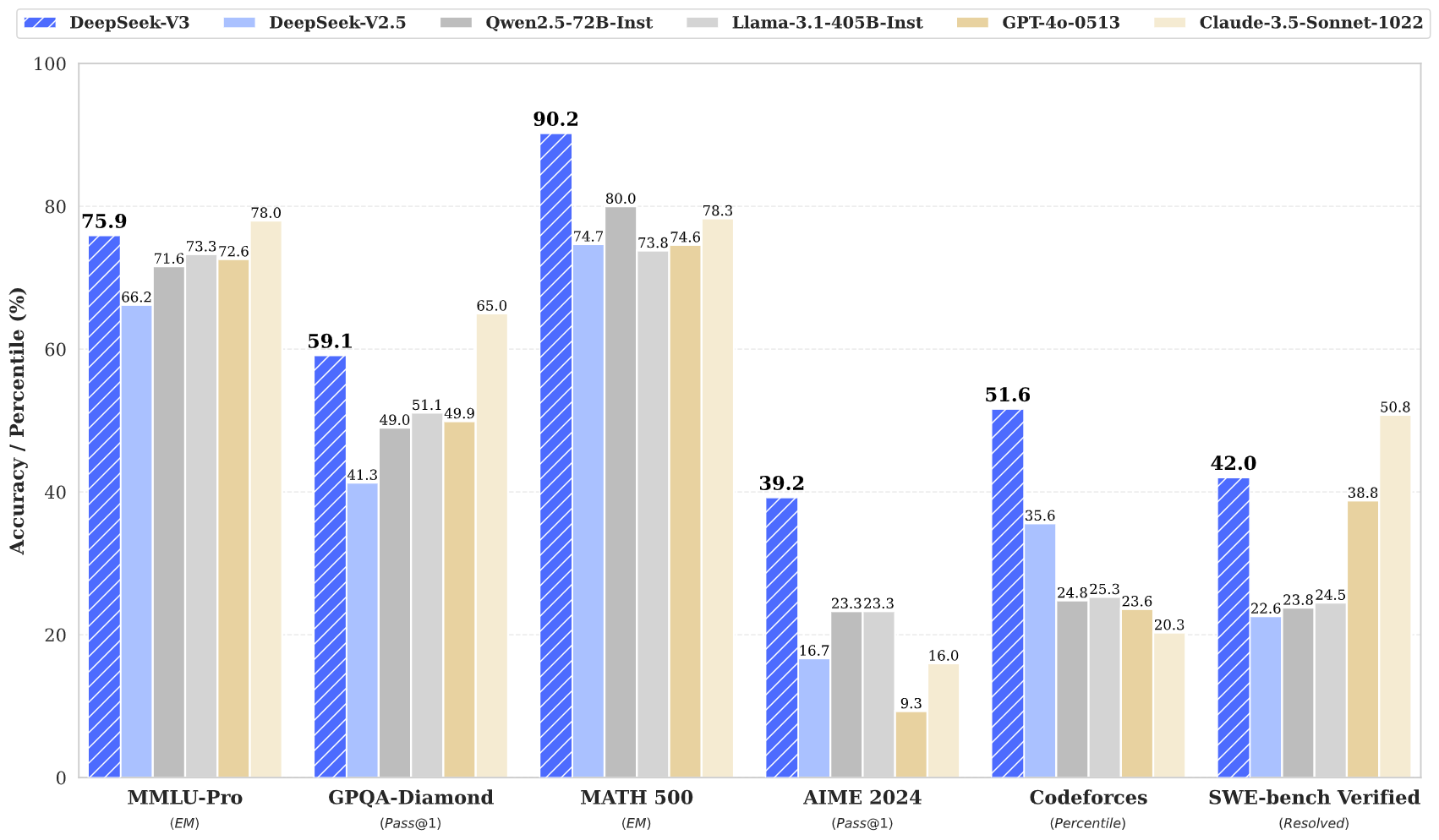

DeepSeek V3 在多項基準測試中展現傑出表現:

- MMLU:87.1%

- BBH:87.5%

- DROP:89.0%

- HumanEval:65.2%

- MBPP:75.4%

- GSM8K:89.3%

這些數據顯示,DeepSeek V3 不僅可與 GPT‑4、Claude 3.5 等封閉源模型競爭,甚至在複雜推理與程式設計任務上時常勝出。

訓練效率

DeepSeek V3 的訓練以卓越效率完成:

- 總訓練成本:約 560 萬美元

- 訓練時長:57 天

- GPU 小時數:僅 278.8 萬 H800 GPU 小時

此高效策略展現創新架構如何相較傳統模型帶來可觀節省,後者往往需要顯著更高的資源投入。

上下文視窗與速度

DeepSeek V3 支援高達 128,000 token 的上下文視窗,能有效處理長篇內容與複雜任務;同時生成速度可達 每秒 90 token,名列當今最快模型之林。

結論

總結而言,DeepSeek V3 是開源 AI 技術的一次重大躍進。其創新架構(MoE、MLA)、高效訓練策略與亮眼效能,使其成為激烈競爭中的強勁對手。面對對強大且可取得之 AI 解決方案的日益增長需求,DeepSeek V3 具備引領 AI 技術民主化的理想條件。

DeepSeek V3 是開源 AI 發展的重要里程碑:以尖端架構結合卓越效率。其效能數據與創新證明,高品質模型可在遠低於傳統成本下實現,讓先進 AI 技術更容易為大眾所用。