DeepSeek V3의 기술 혁신 살펴보기

January 7, 2025

DeepSeek V3의 기술 혁신 살펴보기

DeepSeek V3는 혁신성과 효율성을 겸비한 오픈 소스 AI 모델로 자리매김했습니다. 6,710억 개의 파라미터를 보유하면서도 토큰당 실제 활성화되는 파라미터는 370억 개에 불과하여, 성능을 극대화하면서 자원 소모를 최소화합니다. 본 글에서는 DeepSeek V3를 경쟁 모델과 차별화하는 핵심 기술 혁신을 살펴봅니다.

핵심 기술 특징

Mixture‑of‑Experts(MoE) 아키텍처

DeepSeek V3의 핵심에는 Mixture‑of‑Experts(MoE) 아키텍처가 있습니다. 이 정교한 설계는 작업별로 특화된 소형 네트워크 여러 개를 협업 방식으로 활용합니다. 질의가 들어오면 게이팅 네트워크가 어떤 전문가를 활성화할지 결정하여, 필요한 구성 요소만 동작하도록 합니다. 이러한 선택적 활성화는 효율성과 성능을 크게 향상시킵니다.

Multi‑head Latent Attention(MLA)

DeepSeek V3는 **Multi‑head Latent Attention(MLA)**를 적용하여 문맥 이해와 정보 추출 능력을 강화합니다. 이 접근법은 높은 성능을 유지하면서도 저랭크 압축을 통해 추론 시 메모리 사용량을 줄입니다. 그 결과, 정확도를 유지한 채 복잡한 질의를 효율적으로 처리할 수 있습니다.

보조 손실 없이 수행되는 부하 분산

DeepSeek V3의 주목할 만한 혁신 중 하나는 보조 손실(auxiliary loss)에 의존하지 않는 부하 분산 전략입니다. 기존 방법은 모델 성능을 저하시킬 수 있지만, 이 새로운 접근은 그 영향을 최소화하여 보다 안정적이고 효율적인 학습을 가능하게 합니다.

멀티 토큰 예측 목표

DeepSeek V3는 멀티 토큰 예측을 학습 목표로 도입하여, 일관되고 문맥에 맞는 텍스트 생성 능력을 강화합니다. 여러 토큰을 동시에 예측함으로써 생성 속도와 전체 효율성이 향상됩니다.

성능 지표

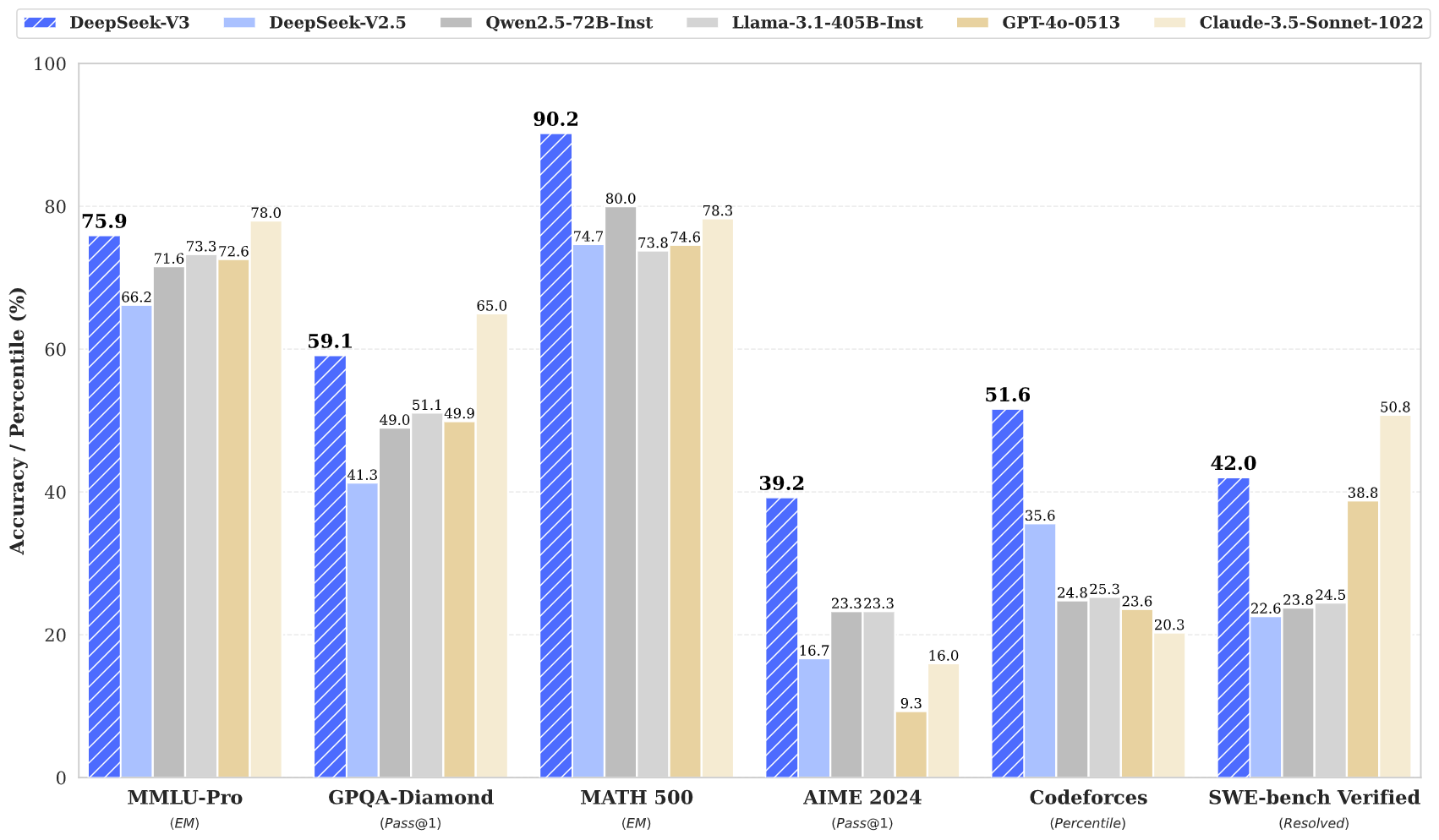

DeepSeek V3는 다양한 벤치마크에서 탁월한 성능을 입증했습니다.

- MMLU: 87.1%

- BBH: 87.5%

- DROP: 89.0%

- HumanEval: 65.2%

- MBPP: 75.4%

- GSM8K: 89.3%

이러한 수치는 DeepSeek V3가 GPT‑4 및 Claude 3.5와 같은 클로즈드소스 최상위 모델과 경쟁하거나, 때로는 능가함을 보여줍니다. 특히 복잡한 추론 및 코딩 과제에서 두드러집니다.

학습 효율성

DeepSeek V3의 학습은 주목할 만한 효율성으로 완료되었습니다.

- 총 학습 비용: 약 560만 달러

- 학습 기간: 57일

- 필요 GPU 시간: 278.8만 H800 GPU 시간

이 비용 효율적인 접근은 전통적 모델에 비해 혁신적 아키텍처가 얼마나 큰 자원 절감을 이끌어내는지 보여줍니다.

컨텍스트 윈도우와 속도

DeepSeek V3는 128,000 토큰의 컨텍스트 윈도우를 지원하여, 장문 콘텐츠와 복잡한 작업을 효과적으로 처리합니다. 또한 최대 초당 90 토큰의 생성 속도를 달성하여, 현재 사용 가능한 모델 중에서도 매우 빠른 편에 속합니다.

결론

요약하면, DeepSeek V3는 오픈 소스 AI 기술의 혁신적 도약이라 할 수 있습니다. MoE와 MLA라는 혁신적 아키텍처, 효율적인 학습 전략, 뛰어난 성능 지표가 결합되어 치열한 경쟁 환경에서 강력한 경쟁력을 제공합니다. 강력하고 접근 가능한 AI 솔루션에 대한 수요가 증가하는 가운데, DeepSeek V3는 AI 기술의 민주화를 이끌 위치에 있습니다.

DeepSeek V3는 최첨단 아키텍처와 뛰어난 효율성을 결합한 오픈 소스 AI 개발의 중요한 이정표입니다. 성능 지표와 혁신은 고품질 AI 모델이 기존 비용의 일부만으로도 개발될 수 있음을 보여주며, 첨단 AI 기술의 대중적 접근성을 높입니다.